第一作者崔巍,北京人形机器人创新中心感知算法负责人;共同一作王浩宇,极佳科技算法工程师,项目负责人;通讯作者张强,北京人形机器人创新中心学术委员会主任。

凭借类人化的结构设计与运动模式,人形机器人被公认为最具潜力融入人类环境的通用型机器人。其核心任务涵盖操作 (manipulation)、移动 (locomotion) 与导航 (navigation) 三大领域,而这些任务的高效完成,均以机器人对自身所处环境的全面精准理解为前提。

然而,传统感知系统存在明显局限:有些仅能适配特定场景,难以应对复杂多变的真实环境;有些无法有效融合多种传感器信息,导致数据利用率低下。这直接造成机器人在实际应用中频繁出现感知失效问题,严重制约了任务执行效率。

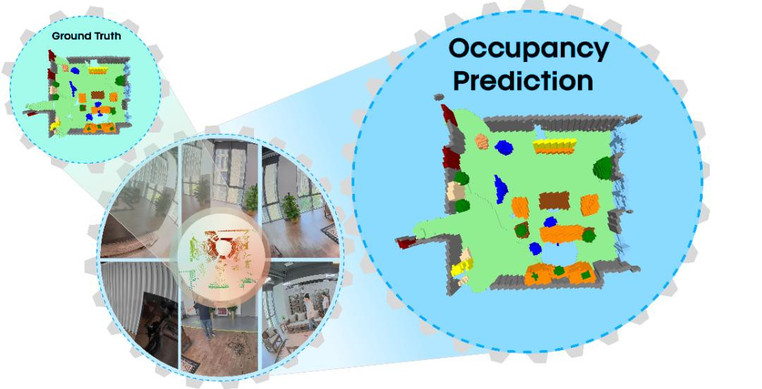

为此,北京人形机器人创新中心推出 Humanoid Occupancy 感知系统,为破解这一行业难题提供了革命性方案。该系统通过创新性融合多模态传感器信息,构建起基于语义占用 (occupancy) 表征的通用感知框架,能够精准捕捉环境中的语义属性与几何特征,为机器人的任务规划和导航决策奠定坚实基础,也为人形机器人向实际场景大规模部署迈出了关键的一步。

- 论文标题:Humanoid Occupancy: Enabling A Generalized Multimodal Occupancy Perception System on Humanoid Robots

- 论文地址:https://arxiv.org/abs/2507.20217

- 项目主页:https://humanoid-occupancy.github.io/

- 联系邮箱:jony.zhang@x-humanoid.com

突破传统感知局限,占用表征具有核心优势

人形机器人面临三大核心任务:操作、移动和导航。操作需要丰富的纹理和几何信息,移动依赖地形几何感知,导航则要求全局环境语义和空间几何理解。这些多样化需求对感知系统设计提出了巨大挑战,而传统的感知表示方法往往只能反映部分信息,无法满足复杂任务需求。

因此,Humanoid Occupancy 系统选择语义占用表征作为人形机器人感知的核心范式,其具备两大显著优势:

- 三维空间全面编码:通过体素直接编码环境中每个空间单元的占据状态与语义类别,不仅能精准捕捉二维平面分布特征,更能完整呈现垂直维度的精细结构及语义属性,其表征能力显著优于传统的 BEV (鸟瞰图) 表征方式。

- 天然适配多模态融合:相较于点云、网格等其他三维表示方法,语义占用可将 RGB 图像、深度信息、LiDAR 点云等多类传感器数据方便地统一整合至空间体素中,使得该系统在数据结构规范性、语义标注便捷性及下游任务接口兼容性上更具通用性与可扩展性,能够直接为路径规划、障碍规避及操作执行等任务提供支撑。

三大关键技术,构建完整感知体系

Humanoid Occupancy 系统构建了一套覆盖硬件布局、数据集构建及多模态融合网络设计的全链条解决方案,为人形机器人提供了通用化的感知技术路线。

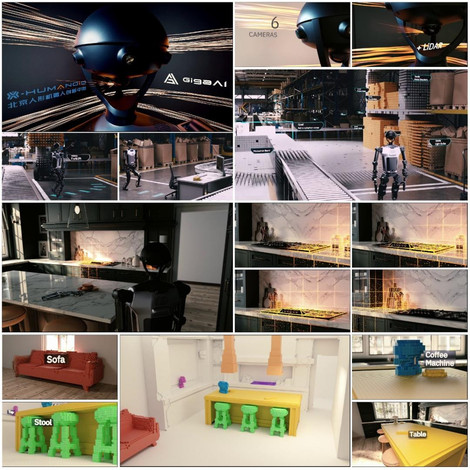

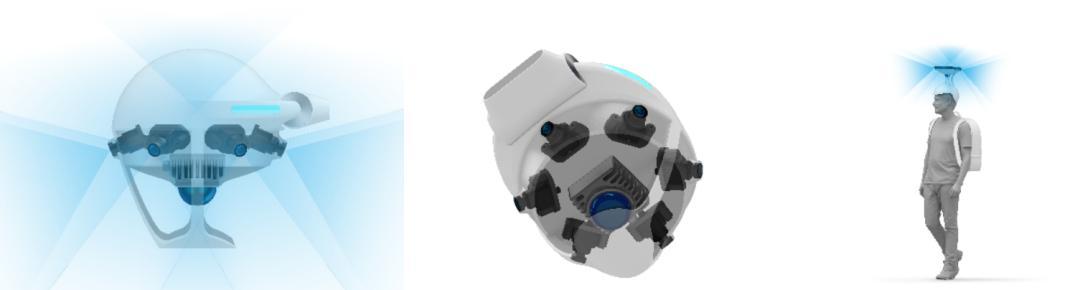

- 优化传感器布局,最大化感知能力:为兼顾操作、移动和导航任务的感知需求,系统采用了创新的传感器布局策略:配备6个RGB相机和1个激光雷达,其中6个相机前后各1个、两侧各2个,激光雷达的水平视场角为360度。同时针对人形机器人的特性,设计了科学合理的安装方案,有效避免了设备遮挡问题,保证了360度感知范围,并确保兼容不同场景和未来迭代升级。

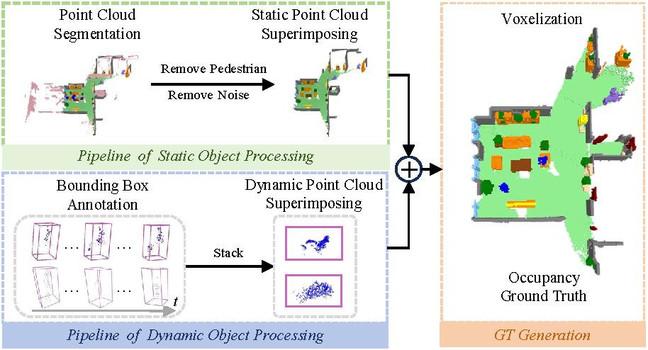

- 构建首个人形机器人全景占用感知数据集,助力社区研究:为解决人形机器人领域数据稀缺问题,团队构建了首个针对人形机器人的占用感知数据集。数据集涵盖家居、工业等多种场景,针对不同场景定义了差异化的语义标注类别(如家居场景包括行人、椅子、桌子等,工业场景包括传送带、静态物体等)。标注采用了精心设计的动静态解耦标注方法,分别针对动态目标(如行人)进行 bounding box 标注,静态点云进行逐点语义标注,最终逐帧合并生成占用真值。

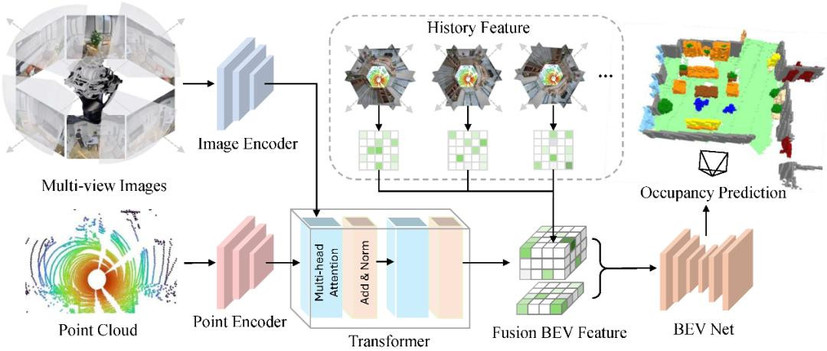

- 设计多模态融合感知网络,实现精准环境感知:为了实现精确且高效的三维占用感知,我们设计了轻量化的多模态时序融合占用感知网络。该网络首先使用各模态专用的编码器分别提取图像和点云特征。然后通过Transformer 解码器实现跨模态的可变形注意力融合。为了进一步提高感知性能,我们记录历史BEV特征,并将其对齐到当前时刻自车坐标系中,然后融合跨时序多尺度BEV特征。最终,我们将BEV特征拉升到三维空间预测最终结果。

实验结果优异,实现性能和效率的平衡

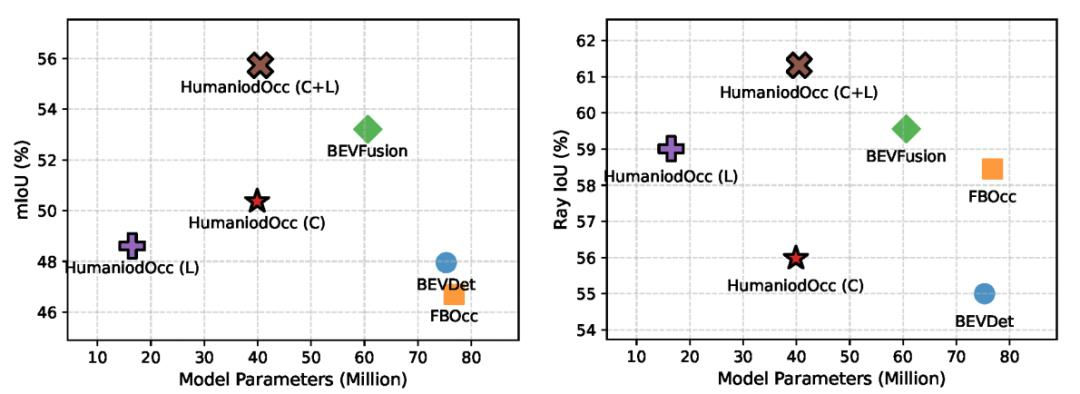

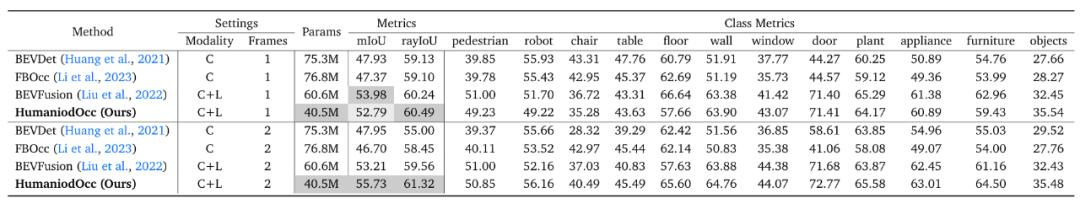

基于采集的多样化场景数据,团队同步构建了数据集与 Benchmark。我们使用 mIoU 和 rayIoU 来衡量三维空间语义分割精度,同时统计模型参数量衡量模型规模。

- 对比试验

我们在该数据集上,将我们的方法与具有代表性的 BEV 感知模型进行了训练和测试。所有模型均采用相同的训练配置,包括输入图像分辨率、骨干网络结构、特征维度和训练策略。结果显示,我们的模型在取得更优指标的同时,还保持了轻量化架构,参数数量更少。

- 消融实验

我们通过消融实验验证了每一个设计的有效性。具体来说,我们分析了相机畸变修正策略、时序信息聚合和输入模态数据的影响。

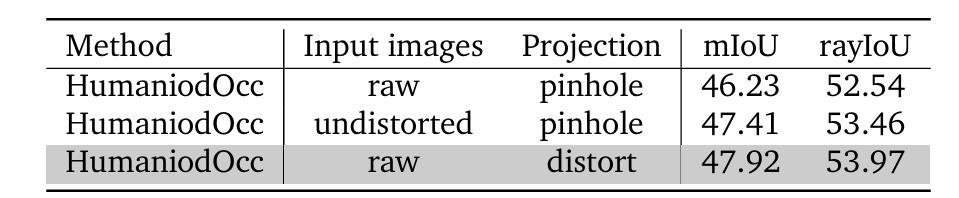

- 相机畸变:我们针对输入图像和投影方法进行实验,实验结果表明,在输入原始图像,并使用考虑畸变的投影方法进行视角变换能够实现最优的性能。

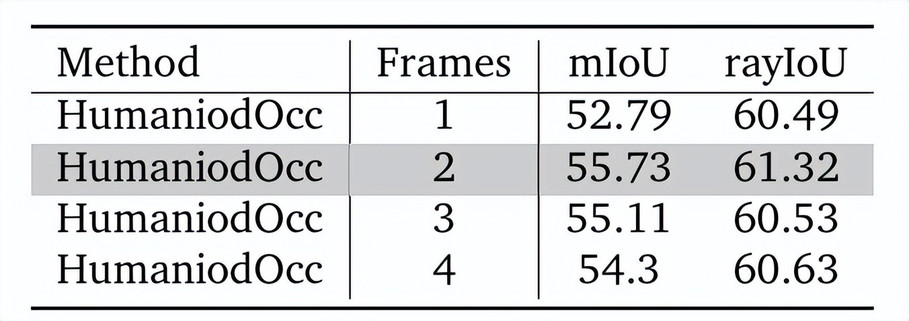

- 时序聚合:我们对所聚合的 BEV 特征数量进行实验。实验结果表明,我们提出的时序融合模块能够有效聚合历史特征,相比单帧模型获得显著提升。

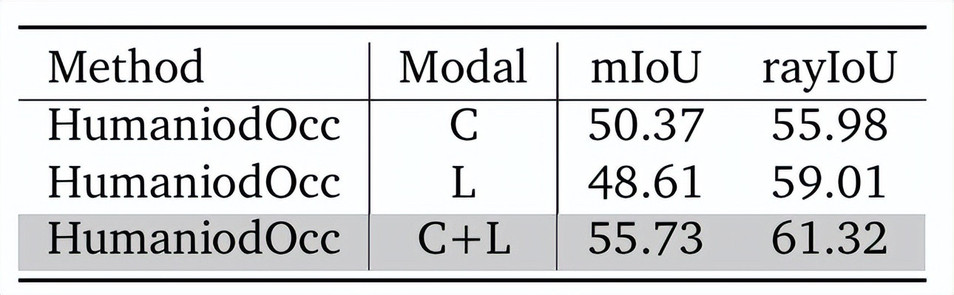

- 模态融合:多模态模型相比只有相机和只有激光雷达的模型具有显著性能优势。这印证了图像和点云的互补特性——点云提供深度等几何信息而图像提供丰富的语义信息。

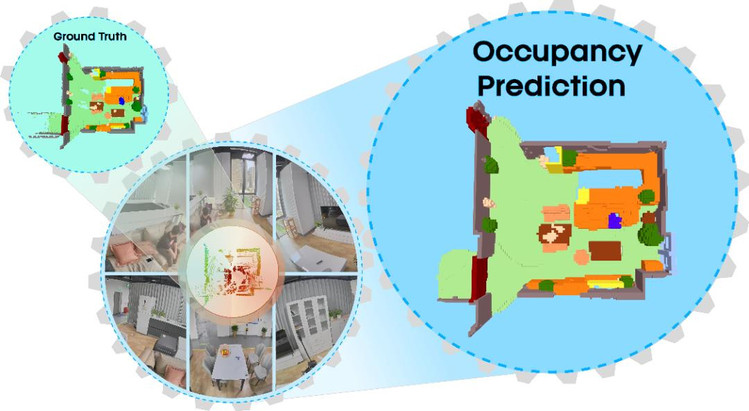

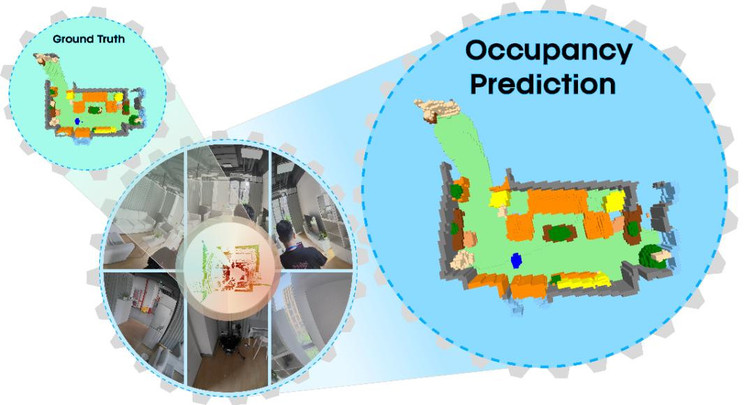

- 可视化结果

我们展示了典型感知结果,可以发现得益于图像和点云的深度融合,该方法能够实现精准的语义占用感知。

推动人形机器人迈向通用化感知时代

Humanoid Occupancy 系统的推出,不仅为人形机器人提供了强大的环境感知能力,更解决了传感器布局、数据标注和多模态融合等关键挑战,奠定了通用感知模块标准化的技术基础。此外,我们构建了首个人形机器人的全景占用感知数据集,并在天工机器人上验证了该系统的有效性。

未来,团队计划进一步扩展数据集、优化时序融合策略,并探索在更多人形机器人平台上的应用。随着技术的不断成熟,人形机器人有望在家庭服务、工业协作、户外救援等多个领域发挥重要作用,为人类生活带来更多便利。

想了解更多关于 Humanoid Occupancy 的详细信息,可参考项目主页以及技术报告。