你有没有想过,人类记忆的局限性可能彻底被AI改写?想象一下,如果有一个AI助手能够24小时不间断地聆听你的生活,记住每一次对话、每一个想法,并在你需要时准确地回调这些信息,那会是什么样的体验?三位前Google X科学家正在将这个看似科幻的想法变成现实,他们刚刚为此获得了570万美元的种子轮融资。

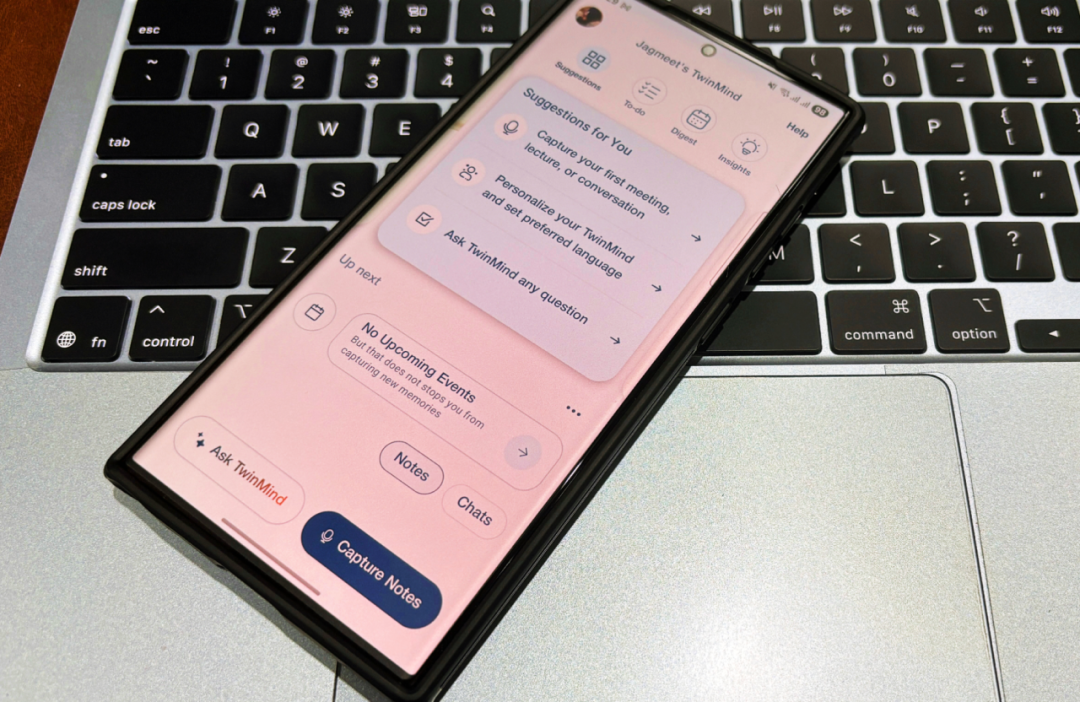

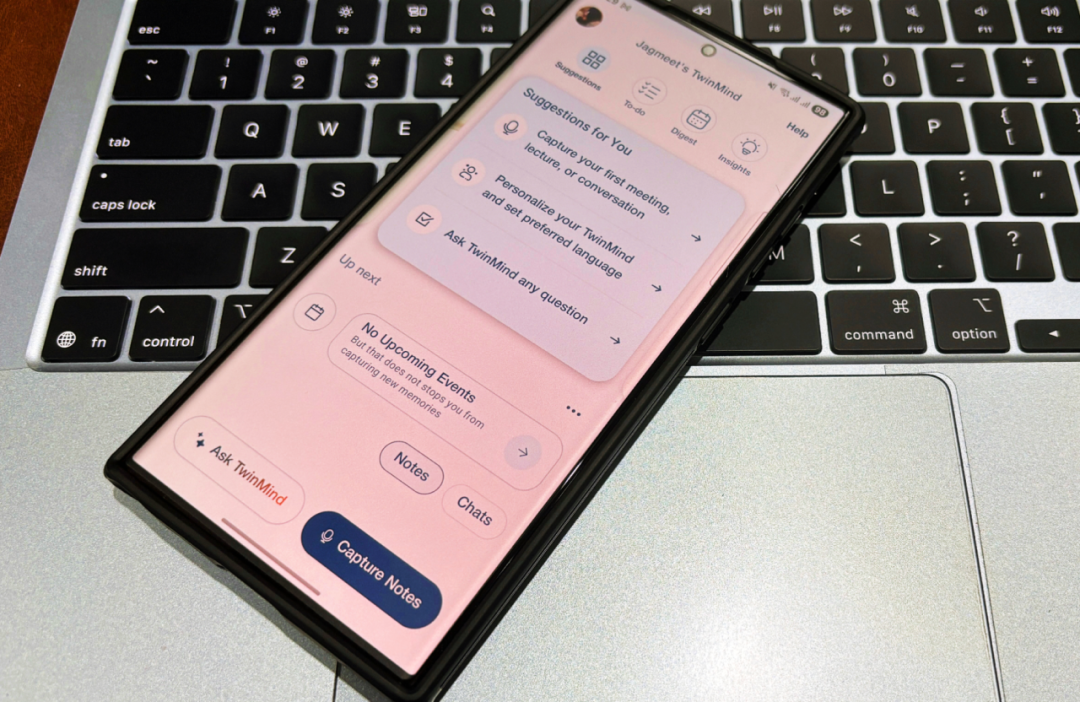

TwinMind不是又一个聊天机器人,而是一个试图成为你"第二大脑"的AI应用。它静静地在你的手机后台运行,捕捉你的每一次谈话、每一场会议,甚至是你无意中说出的想法,然后将这些碎片化的信息整合成一个个人化的知识图谱。更令人惊讶的是,这一切都在你的设备本地完成,不需要将敏感信息上传到云端。我发现这种技术路径的选择背后,隐藏着对AI助手未来发展方向的深度思考。这不仅仅是技术创新,更是对人机交互范式的全新定义。

从投资方的阵容来看,这个项目已经吸引了硅谷顶级投资人的关注。Streamlined Ventures领投了这轮融资,红杉资本也参与其中,最值得注意的是,Stephen Wolfram亲自为这个项目写下了人生第一张投资支票。这种投资者的背书让我相信,TwinMind代表的不仅仅是一个产品,而是整个AI助手行业即将迎来的重大转折点。

为什么现在是"第二大脑"的时代

我一直在思考一个问题:为什么ChatGPT、Claude这些强大的AI工具,在日常使用中仍然让人感觉"不够智能"?答案其实很简单,它们缺乏记忆。每次对话都像是第一次见面,你需要重新解释背景、重新提供上下文,这种体验离真正的智能助手还有很大距离。TwinMind的创始人Daniel George在JPMorgan工作时深深体验了这种痛点,当时他每天要参加无数个会议,于是他开发了一个脚本来录制音频、转录文本,并输入到ChatGPT中。神奇的事情发生了,随着时间的推移,ChatGPT开始真正理解他的项目,甚至能生成可用的代码。

这个经历让George意识到,记忆是AI助手的关键缺失环节。当前的AI工具就像患有失忆症的天才,每次交互都从零开始。而人类的智能很大程度上来自于我们能够积累经验、建立联系、形成个人化的知识体系。TwinMind正是要为AI补上这块拼图,让它真正理解你这个人,理解你的生活、工作和思考方式。

但记忆带来的不仅仅是便利,更是AI助手向真正个人化转变的基础。想象一下,当AI知道你过去三个月一直在关注的项目、你的工作风格、你的合作伙伴,它就能提供真正有价值的建议,而不是千篇一律的通用回答。这种个人化程度是目前任何云端AI服务都无法达到的,因为它们缺乏持续的、深度的用户背景理解。

从技术发展的角度看,我们正处在一个关键节点。移动设备的AI处理能力已经足够强大,可以在本地运行复杂的语言模型。Apple Silicon的AI核心、高效的本地转录技术,这些硬件基础设施的成熟,为像TwinMind这样的应用提供了技术可能性。同时,用户对隐私的关注也达到了前所未有的高度,本地处理的优势变得更加明显。这些因素的汇合,创造了"第二大脑"应用爆发的完美时机。

TwinMind的技术创新究竟有多厉害

让我印象最深刻的是TwinMind在技术实现上的巧思。大多数竞争对手,比如Otter、Granola这些会议记录工具,都是基于React Native构建,依赖云端处理。但苹果的系统限制让这些应用无法在后台长时间运行。TwinMind团队却选择了一条更艰难但更有效的路径:用纯Swift构建底层服务,直接在iPhone上原生运行。George告诉我们,他们花了六到七个月时间来完善这个音频捕捉系统,"在苹果的围墙花园中找到了很多技巧"。

这种技术选择带来的好处是显而易见的:TwinMind可以连续录制16到17个小时而不会耗尽设备电池。这意味着你可以在一整个工作日中保持应用运行,捕捉所有重要的对话和想法。更重要的是,所有处理都在设备本地完成,音频实时转录为文本,然后音频文件立即删除,只保留转录的文本内容。这种"即录即删"的设计不仅保护了隐私,也解决了存储空间的问题。

但TwinMind的创新不仅限于移动应用。他们还开发了一个Chrome扩展,能够通过视觉AI扫描你打开的浏览器标签页,理解来自邮件、Slack、Notion等各种平台的内容。这种多模态的信息收集能力让我想起了真正的个人助理,他们不仅听你说什么,还会观察你在做什么。George甚至用这个扩展来筛选实习生简历,"我们打开了854个申请者的LinkedIn档案和简历,然后让Chrome扩展对最佳候选人进行排名,效果非常好。"

从技术架构上看,TwinMind采用了一种智能的混合模式。大部分处理在设备本地完成,使用针对不同任务优化的本地语言模型。但当遇到复杂查询时,应用会连接到云端的更强大模型,比如ChatGPT、Gemini或Claude。这种设计让成本降低了20倍,因为大部分工作不需要昂贵的云端计算。同时,即使在没有网络连接的情况下,TwinMind依然能够正常工作,这对于经常出差或在网络不稳定环境中工作的用户来说非常重要。

最让我惊喜的是TwinMind的语音识别能力。他们最新的Ear-3模型支持超过140种语言,单词错误率仅为5.26%,还能区分对话中的不同说话者,说话人分离错误率只有3.8%。这个模型是在精心策划的人工标注数据集上训练的,包括播客、视频和电影内容。George发现了一个有趣的规律:"支持的语言越多,模型就越擅长理解口音和方言,因为它在更广泛的说话者范围内进行训练。"这种技术洞察说明了TwinMind团队对语音识别技术的深度理解。

从Google X到创业:经验的价值

Daniel George的背景让这个项目更加引人注目。在加入Google X之前,他曾在诺贝尔奖获奖团队LIGO中工作,将深度学习应用于引力波天体物理学。24岁时就完成了AI天体物理学博士学位,这样的学术背景让他在2017年加入了Stephen Wolfram的研究实验室。这段经历最终形成了一个完美的闭环:Wolfram后来成为TwinMind的第一位投资人,这也是这位科学家的首次创业投资。

但真正塑造TwinMind的,是George在Google X的经历。他在那里参与了六个不同的项目,包括iyO团队开发的AI驱动耳机项目。George告诉我们:"Google X实际上是创办自己公司的完美准备地。任何时候都有大约30到40个类似创业公司的项目在进行。没有人能在如此短的时间内在六个早期创业公司工作两三年,然后再推出自己的公司。"这种经历给了团队从概念到产品快速迭代的能力。

TwinMind的另外两位联合创始人Sunny Tang和Mahi Karim也都来自Google X。Tang是首席技术官,Karim是首席科学家。这个三人团队现在住在湾区的同一所房子里,George说他们"在过去一年半里每周工作100小时"。这种极度专注的工作状态让我想起了早期的科技创业公司,那种为了改变世界而全身心投入的精神状态。

从Google X到TwinMind的转变,体现了一种有趣的创新模式。大公司的研发实验室为创新者提供了资源和经验,但真正突破性的产品往往需要创业公司的灵活性和专注度。George在Google X学到的不仅仅是技术,更重要的是如何管理高风险的创新项目,如何在不确定性中寻找方向。这种经验对于TwinMind这样需要突破技术边界的项目来说是无价的。

有趣的是,George在JPMorgan的经历也为TwinMind提供了重要启发。作为副总裁和应用AI负责人,他每天都要参加无数会议,这让他切身体验了信息过载的痛苦。他开发的那个简单脚本,虽然粗糙,但证明了AI记忆的巨大价值。当他把这个想法分享给朋友,并在Blind上发布时,其他人的兴趣让他意识到这是一个普遍的痛点,而不仅仅是个人需求。

用户反馈揭示的真实需求

TwinMind目前已经有超过30000名用户,其中15000人是月活跃用户。这个数字让我很好奇用户究竟如何使用这个应用,以及它是否真的解决了实际问题。从用户构成来看,50%到60%是专业人士,25%左右是学生,剩下20%到25%是个人用途。这种多样化的用户群体说明了"第二大脑"的需求是跨越职业和年龄界限的。

特别有意思的是,George的父亲也在使用TwinMind来写自传。这个使用案例让我意识到,记忆助手的价值不仅仅在于工作效率,更在于帮助人们整理和保存人生经历。对于年长者来说,TwinMind可能成为一种数字化的记忆保险,帮助他们捕捉和记录可能被遗忘的珍贵回忆。

用户地理分布也很有启发性。虽然美国是最大的用户基础,但TwinMind在印度、巴西、菲律宾、埃塞俄比亚、肯尼亚和欧洲也获得了显著增长。这种全球化的接受度说明了记忆增强的需求是普遍的,不受文化和地域限制。同时,TwinMind支持100多种语言的事实,也让它能够真正服务全球用户,而不仅仅是英语用户。

从产品使用模式来看,20%到30%的TwinMind用户也在使用Chrome扩展。这个数字说明了多模态信息收集的价值。用户不仅需要记录口头交流,也需要记录他们的数字活动。这种行为模式验证了TwinMind的产品方向:真正的个人AI助手需要全方位地理解用户,而不仅仅是某一个维度。

最让我印象深刻的是用户粘性。George预测:"一旦人们使用它,他们就不会停止使用。我离不开它了。"虽然这听起来像是创始人的偏见,但考虑到TwinMind的增长数字和用户反馈,这种说法可能并非夸张。当一个工具真正解决了用户的核心痛点,并且使用体验足够流畅时,它确实会成为用户生活中不可或缺的一部分。

隐私与安全:本地化的价值

在AI应用普遍依赖云端处理的今天,TwinMind选择本地化处理的策略显得格外引人注目。George一再强调,TwinMind不会在用户数据上训练模型,所有录音都在本地实时转录后立即删除,只有转录的文本被保存在应用中。这种设计哲学背后,体现了对用户隐私的深度思考。

我认为这种本地化处理不仅仅是技术选择,更是对AI应用未来发展方向的重要预判。随着用户对隐私保护意识的提高,以及各国对数据保护法规的加强,能够在本地处理敏感信息的AI应用将具备明显的竞争优势。TwinMind的这种设计让它能够记录最私密的对话和想法,而用户不用担心这些信息被上传到某个云端服务器。

但本地化处理也带来了技术挑战。如何在有限的移动设备资源上运行复杂的AI模型?如何在保证效果的同时控制电池消耗?TwinMind团队的解决方案是使用多个针对不同任务优化的小型模型,然后在需要时调用云端的大型模型。这种混合架构在效率和效果之间找到了平衡点。

从商业角度看,本地化处理还带来了成本优势。George提到,这种架构让成本降低了20倍,因为大部分处理不需要昂贵的云端计算资源。这种成本结构让TwinMind能够提供免费版本,同时在付费版本中提供更高级的功能。免费版包含所有基本功能,包括无限时长的转录和本地语音识别,而15美元/月的Pro版本则提供更大的上下文窗口(高达200万tokens)和24小时内的邮件支持。

我发现TwinMind在隐私保护上的另一个巧思是,它不让用户事后访问音频记录。音频被实时转录后立即删除,只保留文本内容。这种设计既保护了隐私,也避免了存储大量音频文件的问题。对于用户来说,他们得到的是结构化的、可搜索的信息,而不是需要重新听取的原始录音。

当然,本地化处理也不是万能的。对于某些复杂任务,云端的大型模型仍然具有优势。TwinMind的策略是让用户选择:如果你需要更强大的AI能力,可以选择连接云端模型;如果你更关注隐私,本地模型已经能够满足大部分需求。这种灵活性让不同需求的用户都能找到适合的使用方式。

市场竞争:为什么TwinMind与众不同

在AI助手领域,TwinMind面临着激烈的竞争。从传统的Siri、Alexa,到新兴的ChatGPT、Claude,再到专门的会议记录工具如Otter、Fireflies,市场上已经有很多解决方案。但我认为TwinMind的差异化策略是明智的,它没有试图在所有方面都做到最好,而是专注于一个核心优势:记忆。

与传统AI助手相比,TwinMind的优势在于持续性。Siri和Alexa虽然能够回答问题和执行任务,但它们无法建立对用户的深度理解。每次交互都是独立的,无法形成连续的对话和关系。ChatGPT和Claude虽然在对话能力上更强,但它们缺乏对用户个人生活的了解。TwinMind则通过连续的背景录制,能够真正理解用户的生活、工作和思考模式。

与专门的会议记录工具相比,TwinMind的优势在于全面性。Otter、Granola这些工具主要针对特定场景,比如会议或讲座。而TwinMind则试图捕捉用户生活的方方面面,不仅仅是正式的会议,还包括非正式的对话、个人思考,甚至是偶然听到的有用信息。这种全面性让它能够建立更完整的个人知识图谱。

我特别注意到TwinMind在技术实现上的优势。很多竞争对手使用React Native和云端处理,这让它们无法在iOS后台长时间运行。TwinMind选择用纯Swift构建,并在本地处理大部分任务,这给了它技术上的护城河。这不是一个容易复制的优势,需要深度的iOS开发经验和对苹果系统限制的深入理解。

从产品定位来看,TwinMind也很聪明地避开了一些红海竞争。它没有试图成为通用的搜索工具或问答系统,而是专注于个人记忆增强这个细分领域。这个定位让它能够在功能上保持专注,在用户心中建立清晰的品牌认知。

但我也看到了TwinMind面临的挑战。苹果和谷歌这样的平台公司,完全有能力在系统层面集成类似的功能。实际上,苹果的Siri和谷歌的Assistant已经在朝这个方向发展,虽然步伐相对缓慢。TwinMind需要在大公司意识到这个市场机会并大举进入之前,建立足够的用户基础和技术壁垒。

我认为TwinMind的成功很大程度上取决于它能否持续创新,保持技术领先。仅仅是"记忆"这一个特性可能不足以长期抵御竞争。但如果它能够基于记忆能力,开发出更多独特的功能和使用场景,就有可能建立起可持续的竞争优势。

AI助手的未来:从工具到伙伴

通过研究TwinMind,我对AI助手的未来发展有了更深的思考。目前大多数AI工具本质上仍然是"工具",用户需要主动调用它们,告诉它们要做什么。但TwinMind代表了一种新的方向:从被动的工具转向主动的伙伴。它不需要用户明确的指令,而是通过观察和学习,主动提供有价值的信息和建议。

这种转变的核心是上下文理解能力。当AI能够理解用户的全部背景,包括最近的对话、正在进行的项目、个人偏好和行为模式时,它就能提供更有价值的帮助。比如,当你准备见一个客户时,AI不需要你明确要求,就能自动提醒你上次与这个客户讨论的关键问题,或者提供相关的背景信息。

我特别关注TwinMind的"主动性"特征。George描述它能够"在你甚至还没提问之前就主动帮助你"。这种能力需要AI不仅理解用户说了什么,还要理解用户的意图和需求。这是一个巨大的技术挑战,但也代表了AI助手的未来方向。

从长期来看,我认为个人化AI助手将成为我们数字生活的中心。就像智能手机改变了我们的生活方式一样,真正智能的AI助手也将带来类似的变革。它们不仅能记住我们说过的话,还能理解我们的价值观、目标和行为模式,成为真正的数字伙伴。

但这种发展也带来了新的挑战和问题。当AI助手变得如此了解我们时,数据安全和隐私保护变得更加重要。如何确保这些深度个人化的信息不被滥用?如何在便利性和隐私之间找到平衡?TwinMind的本地化处理策略提供了一种解决思路,但这可能不是唯一的答案。

另一个值得思考的问题是依赖性。当我们习惯了AI助手记住一切、提醒一切时,我们自己的记忆能力会不会退化?这就像导航软件让很多人失去了认路的能力一样。如何在利用AI增强能力的同时,保持人类自身的认知能力,这是一个需要深入思考的问题。

我还注意到,个人化AI助手的发展可能会创造出一种新的数字不平等。那些能够负担得起高质量AI助手的人,将在信息处理、决策制定、学习能力等方面获得巨大优势。这种优势可能会放大现有的社会不平等。如何确保这种技术的普惠性,也是一个重要的社会问题。

TwinMind的商业模式与发展前景

TwinMind的商业模式设计得相当聪明。他们提供免费版本来吸引用户,包含所有核心功能:无限时长的转录、本地语音识别、基本的AI交互能力。这种策略降低了用户的试用门槛,让更多人能够体验到"第二大脑"的价值。同时,他们通过Pro版本获得收入,每月15美元,提供更大的上下文窗口、更强的AI模型访问权限和优先客户支持。

从用户获取成本的角度看,TwinMind的策略是可持续的。本地化处理大大降低了运营成本,George提到成本比纯云端方案低20倍。这种成本结构让他们能够承受免费用户的负担,同时通过付费用户实现盈利。这种模式类似于很多成功的SaaS应用,通过免费版本建立用户基础,通过高级功能实现商业化。

我特别关注TwinMind在API商业化方面的计划。他们的Ear-3语音识别模型将通过API提供给开发者和企业,价格为每小时0.23美元。这种B2B2C的模式可能成为重要的收入来源,特别是考虑到TwinMind在多语言语音识别方面的技术优势。支持140多种语言、5.26%的词错率、3.8%的说话人分离错误率,这些技术指标在行业中是有竞争力的。

从融资的角度看,TwinMind的估值增长轨迹也很健康。从最初的3000万美元估值到最新的6000万美元后投资估值,这种增长反映了投资者对其技术和市场前景的认可。特别是Stephen Wolfram的参与,不仅带来了资金,更重要的是带来了信誉背书。作为计算科学领域的权威人物,Wolfram的首次创业投资选择了TwinMind,这个信号的价值可能超过了投资金额本身。

但TwinMind也面临着扩展挑战。目前他们的团队只有11人,虽然这种小团队结构有利于快速决策和产品迭代,但要服务30000用户并持续增长,他们需要在合适的时候扩大团队。特别是在用户体验设计和商务拓展方面,他们已经计划招聘更多人才。

从市场前景来看,我认为个人化AI助手市场刚刚开始。TwinMind目前的用户规模相对较小,但增长潜力巨大。如果他们能够在用户体验和技术能力方面保持领先,有机会在这个新兴市场中建立主导地位。关键是要在大公司注意到这个机会并投入资源之前,建立足够的技术壁垒和用户粘性。

我也看到了TwinMind面临的一些风险。技术风险方面,AI技术发展很快,他们需要持续创新才能保持竞争优势。市场风险方面,用户对隐私的担忧可能会阻碍adoption,特别是在一些隐私敏感的地区和行业。监管风险方面,各国对AI应用的监管政策还在形成中,可能会对产品功能和商业模式产生影响。

文章来自于微信公众号 “深思圈”,作者 “深思圈”