西风 发自 凹非寺

量子位 | 公众号 QbitAI

一觉醒来,宇树带着最新开源模型来了!

这次开源的是一个世界模型-动作架构,名叫UnifoLM-WMA-0。它的核心之处在于拥有一个世界模型能够理解机器人和环境相互作用时的物理规律。

咱先瞧瞧真机部署后的表现。

玩堆积木,稳稳当当。重点是,右上角小窗口呈现出世界模型对后续动作视频的预测,能发现和实际操作情形十分吻合。

两只机械臂搭档干活也可以:

像收纳文具这类稍精细的活儿,都能轻松拿捏:

将相机放入包装盒,世界模型的预测同样和实际操作几乎无差:

视频链接:https://mp.weixin.qq.com/s/z4IQi1hSi7_LAg5_g3mXOQ

官方称,UnifoLM-WMA-0属于UnifoLM(Unitree机器人统一大模型)系列成果,是团队专为通用机器人学习量身打造的,能适配多种机器人本体。

目前UnifoLM-WMA-0训练代码、推理代码、模型Checkpoints通通开源,GitHub迅速揽获100+Star。

网友看后纷纷点赞。

如何训练的?

官方介绍了模型的训练策略,具体流程和设计思路可以拆解成这几步来看。

首先,团队先拿Open-X数据集对视频生成模型做了针对性微调,核心目的就是让模型原本的生成能力适配机器人的实际作业场景。

至于微调后模型在测试集上的实际生成效果,是这样婶儿的:

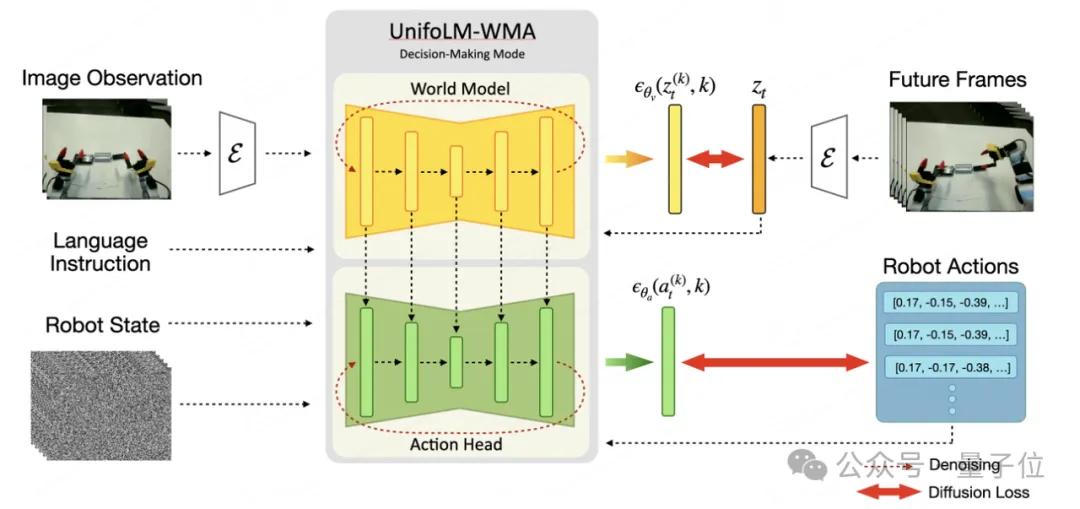

团队进一步提出了基于世界模型打造的策略架构,即UnifoLM-WMA-0。

这个架构里的世界模型不是单一模式运行,而是支持两种核心功能模式。

一种是决策模式,简单说就是能提前预测机器人和环境进行物理交互时的关键信息,辅助策略更精准地生成下一步动作。

另一种是仿真模式,主要是根据机器人已经做出的动作,生成高度还原真实场景的环境反馈,相当于给机器人模拟出一个逼真的交互环境。

针对这两种模式,团队在下游任务数据集上分别做了后训练优化。

以下是完整的系统架构及工作流程:

视频链接:https://mp.weixin.qq.com/s/z4IQi1hSi7_LAg5_g3mXOQ

团队用了宇树科技公开的五个开源数据集,最终完成了全流程训练。

从测试结果来看,这个模型要是当作仿真引擎来用,效果突出。

只要给它“当前场景的图像”,再加上一定数量的“机器人未来要做的动作指令”,它就能实现可控的交互生成,生成的内容能精准匹配预期。

生成结果和原视频的对比情况,大家可以通过下面的图直观感受:

面对长程任务的持续交互生成也能应对,生成结果和原视频的对比如下:

GitHub:https://github.com/unitreerobotics/unifolm-world-model-action/tree/main

项目主页:https://unigen-x.github.io/unifolm-world-model-action.github.io/

— 完 —

量子位 QbitAI · 头条号签约

关注我们,第一时间获知前沿科技动态