机器之心报道

机器之心编辑部

继上周开源三连发之后,阿里昨晚又放出了新模型。

这次是全球首个开源的 MoE 架构的视频生成模型 Wan2.2,最大的亮点是具备了电影级美学控制能力。

该模型遵循 Apache 2.0 开源协议。

- 官网地址:https://wan.video/welcome

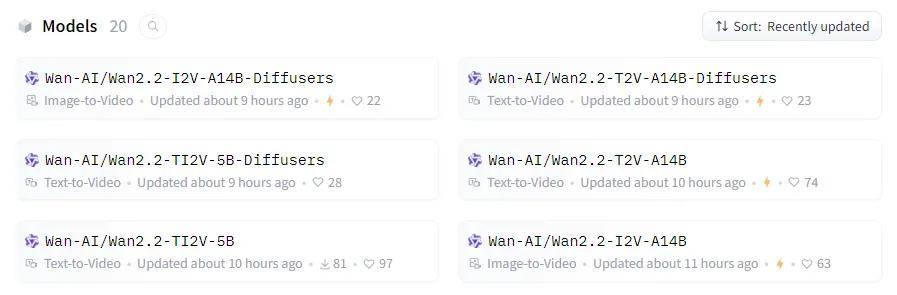

- Hugging Face 地址:https://huggingface.co/Wan-AI

- ModelScope 地址:https://modelscope.cn/organization/Wan-AI

我们先来看两个示例:

提示词:A purely visual and atmospheric video piece focusing on the interplay of light and shadow, with a corn train as the central motif. Imagine a stage bathed in dramatic, warm spotlights, where a corn train, rendered as a stark silhouette, moves slowly across the space. The video explores the dynamic interplay of light and shadow cast by the train, creating abstract patterns, shapes, and illusions that dance across the stage. The soundtrack should be ambient and minimalist, enhancing the atmospheric and abstract nature of the piece.

提示词:A man on the run, darting through the rain-soaked back alleys of a neon-lit city night, steam rising from the wet pavement. He"s clad in a drenched trench coat, his face etched with panic as he sprints down the alley, constantly looking over his shoulder. A chase sequence shot from behind, immersing the viewer deeply, as if the pursuers are right behind the camera lens.

对于 Wan2.2 的开源,评论区的网友也是称赞有加。

而实现这样的效果,Wan2.2 主要得益于以下几大技术创新:

一是,MoE 架构创新。

Wan2.2 首次在视频扩散模型中引入了 Mixture-of-Experts(MoE)专家混合架构。

通过在时间步之间引入多个专门的强大专家模型来分担去噪过程,Wan2.2 实现了在不增加计算成本的前提下,大幅扩展了模型整体容量。

二是,数据规模跃升。

相比 Wan2.1,Wan2.2 的训练数据量大幅提升:图像数据增加 65.6%,视频数据增加 83.2%。

数据量的扩展显著增强了模型在运动表达、语义理解和美学表现等多维度的泛化能力,在所有开源与闭源视频模型中的表现均属顶尖。

三是,电影级美学控制能力。

Wan2.2 融入了特别筛选的美学数据集,并标注了光影、构图、色彩等细粒度属性,使得模型在生成时能够更精准地控制电影感风格,支持用户按需定制审美偏好。

四是,高效高清 Hybrid TI2V 架构。

Wan2.2 同步开源了一款 50 亿参数模型,采用自研的 Wan2.2-VAE 编码器,压缩率达到 16×16×4。该模型支持文本生成视频和图像生成视频两种模式,生成分辨率高达 720P、24fps,并可在消费级显卡(如 4090)上流畅运行。

该模型是当前市场上最快速的 720P、24fps 生成模型之一,可同时服务工业界与学术界的多种需求。

目前,用户可在 Hugging Face 和阿里魔搭(ModelScope)社区下载使用。