卷王指南又更新了,这次还有番外篇。

开源 2.0 :变脸堪比整容

等了一百多天,悬念终于揭晓。

9 月 13 日上午,蚂蚁集团开源团队(「开源技术增长」)携《 2025 大模型开源开发生态全景图 》2.0 版,亮相上海外滩大会。

三个月前,「一场直播中的『现实世界的黑客松 』 (A Real-world Hackathon )」的断言,今天依然成立——

彼时「撕拉片」记录下生态初现的模样,而今,已经大变样。

- 访问地址:

- https://antoss-landscape.my.canva.site/

这一次,全景图收录了 114 个项目(比上一版减少 21 个),覆盖 22 个领域。其中,39 个是新晋项目,同时也有 60 个项目消失在舞台,其中不乏一度高光的 Star 王者——

如 NextChat、OpenManus、FastGPT、GPT4All,因迭代迟缓、社区乏力而被后来者超越。

最 drama的,当属 TensorFlow 的谢幕,这位昔日巨星最终没能抵挡 PyTorch 的攻势,后者自此一统江湖。

灰色部分,即为出局的开源项目

整体趋势是显而易见:生态正在经历一轮剧烈洗牌。就像寒武纪的「生命大爆发」,Agent 层最为汹涌,混沌之中,各类新物种层出不穷。

另一组数据,也侧面印证了这一旺盛的新陈代谢——

算上被淘汰的项目,整个大模型生态的「中位年龄」只有 30 个月,平均寿命不足三年,是一片极度年轻的丛林。

尤其是「GPT 时刻」之后( 2022 年 10 月),62% 的项目才诞生,其中 12 个甚至是 2025 年的新面孔。也就是说,几乎每个季度都能看到新人登场、旧人退场。

更夸张的是,这些年轻项目获得了前所未有的关注:平均 Star 数接近 3 万,远超以往同龄的开源项目。头部前十的项目几乎覆盖了模型生态的全链路,是当下最具代表性的社区力量。

最活跃的开源项目 Top 10

关键词词云也呼应了这一趋势:AI、LLM、Agent、Data成了最大、最亮的几个字。

大模型开发生态关键词 AI、LLM、Agent、Data 、Learning正是第一张图表中所列项目的主要领域。

另一个大变样是全景图的分类框架。

因为看过 1.0 版本,所以当我第一次看到 2.0 全景图时,最直观的感受就是:分类架构变得更具体、更细分:

从大而化之的 Infrastructure / Application,进化为 AI Agent / AI Infra / AI Data 三大板块,清晰勾勒出行业热点(智能体为中心),和技术演进的趋势。

如果说 1.0 的框架还带着传统开源软件生态的影子,那么 2.0 已经透出「智能体时代」的气质。

最后,从全球 366,521 位开发者群像来看,中美双雄贡献超过 55%,依然是项目的绝对领导者,其中美国以 37.41% 的比例位居第一。

在技术领域的细分贡献中,美国在 AI Infra 和 AI Data 上优势明显。

如,AI Infra,美国贡献度达 43.39%,是排名第二的中国的两倍多;而在 AI Data 的领先优势更为明显。

中国在具体应用层( AI Agent )则表现接近美国,两国贡献度分别为 21.5% 和 24.62% ,这与中国开发者在 Agent 层面的投入更多密切相关。

制图论的进化

为什么要把方法论放在前面讲?答案很简单——哪些项目能够进入 2.0 全景图,很大程度上取决于方法论变了。

1.0 版本的方法论是「从已知出发」——被广泛讨论的头部项目,比如 PyTorch、vLLM、LangChain,再通过它们的协作和依赖关系向外延伸。

但出发点决定边界:你从哪些种子项目出发,就决定了能看见的生态范围。那时的入选门槛是 OpenRank (华东师范大学 X-lab 开发的开源影响力指标)月均值 ≥ 10。

而 2.0 版本直接拉取 GitHub 全域项目的 OpenRank 排名,筛选出大模型相关项目,不仅大幅减少了起点偏见,也更敏感于新项目的爆发力。结果是,更多高热度、高活跃度的项目被发现,入选阈值也相应提高到当月 OpenRank > 50。

从这个角度说,2.0 更契合蚂蚁「开源技术增长」团队做这件事的初衷:对内,为企业决策提供依据;对外,为开源世界的「卷王们」点亮指南。

在这套新方法下,三大主力赛道脱颖而出:AI Coding、Model Serving 、LLMOps。

接下来,我们将从应用层一路追溯到底层 Infra,逐一梳理这股洪流中的关键变化。

AI Agent :AI Coding 疯魔了

2.0 全景图上的 AI Agent 已经从一个「百宝箱」式的工具堆,演化为类似云计算的分层体系——

AI Coding、Agent Workflow Platform、Agent Framework、Agent Tool 等类别齐备,专业与清晰度大幅提升,社区正经历从野蛮生长走向系统分化的过程。

2.0的AI Agent 层

AI Agent 的迭代经历犹如过山车。

目前,AI Agent 地表变动剧烈,就像一片新大陆,每个人都在抢先插旗。AI Coding、Chatbot、Workflow Platform 等方向接连涌现出新的高热度项目。

更有意思的是,2.0 版还敏锐捕捉到 AI 与物理世界深度结合的迹象——「小智」尝试把大模型跑在低功耗芯片上,Genesis 则面向通用机器人提供物理仿真平台。

接下来,我们逐一拆解细分领域的变化。

1、从疯到癫,AI Coding 增长曲线仍在陡升

除了 Cline、Continue、OpenHands 等常驻「霸榜」项目外,新面孔不断涌现——Gemini、marimo、Codex CLI,以及定位为 Claude Code 100% 开源替代的 OpenCode。事实再次证明,「Agent for Devs」仍是最高频、最刚需的应用场景。

2025 年的 AI Coding 已经完成了从「补代码」到「全生命周期智能引擎」的跨越:能做的事更多,从开发到运维全链路覆盖;做事的方式更聪明,支持多模态、上下文感知与团队协同。

报告预测,市场也将随之释放出巨大的商业化潜力——付费订阅、SaaS 服务与增值功能,将成为新的盈利模式。

AI Coding 已经完成了从「补代码」进化到能做的事更多,做事的方式更聪明。

这种趋势在行业交流中感受尤深。这次上海外滩大会上,有嘉宾直言 AI Coding 工具卷到用不过来;另一位深耕 AI 编码的 CEO 则透露,团队所有成员的 AI 工具报销已超 200 美元。

几个月前,AI 代码还需要大量人工修正;如今质量飞升,只需轻量修改即可。下一步,AI 编程或许会从「写代码」跃迁到「主导整个工作流」。

值得注意的是,Gemini CLI、Codex CLI 的走红也释放出大厂的战略信号:通过开源工具链绑定开发者,把他们锁入自家闭源模型的生态。

这与微软当年的 Windows + .NET、苹果的 iOS + Swift 如出一辙。今天的AI 巨头,正在用相同的路径重塑新一轮开发者生态。

2、Chatbot & Knowledge Management 高光后的理性回归

Chatbot 是 GenAI 应用的第一波爆款,Cherry Studio、Open WebUI、Lobe Chat、LibreChat 在 2025 年初迎来顶峰,收获了大量关注与贡献。但热度未能持续。5 月之后,Chatbot 进入平台期,逐渐降温。

Lobe-Chat 以日更节奏,用框架将「ChatGPT 式对话」降维到人人可自建的体验。然而,随着功能趋近完备,用户也发现 Chatbot 核心价值仍是「对话」,而对话在生产力上的突破有限。

Cherry Studio 开辟了另一条路径:把 Chatbot 与知识库/笔记结合,定位于「个人知识助理」,更贴近长期生产力需求。这可能也是它逆势上榜的原因——新进项目中活跃度第二,总体位列第七。

因此,降温并不意味着衰退。Lobe-Chat 依然保持 64.7k star 的体量,日更节奏从未停歇。只是相较 Memory、Agent 等更令人兴奋的方向,Chatbot 不再是唯一的焦点,而开始回归理性。

3、Agent Workflow Platform 沉淀为真正的基础设施

当 GPT-5、Claude、Gemini等顶尖模型趋同,AI 应用的差异化越来越依赖「记忆」。这催生了一大批 RAG + Agent 项目,成为开源热点。

RAGFlow、MaxKB(专注知识库问答)、FastGPT(轻量 RAG 平台)、Flowise AI(主打 RAG-based QA 的可视化工作流工具)都在这一波浪潮中走红。

尽管趋势回落,但 7 月份的 OpenRank (1418) 仍然远高于 1 月份的起始点。

相比之下,Dify 的布局更完整:不仅覆盖 RAG 和 Agent 工作流,还提供应用发布、用户管理、可观测性等企业级能力,形成从原型到生产的一站式平台,在社区影响力和商业化上明显领先。

与此同时,新的探索开始突破传统 RAG 的边界。如 Letta(尚未上榜)尝试引入「离线学习」,让 Agent 不仅能依赖检索,还能真正从经验中学习改进。这意味着 Agent Workflow 未来可能从「检索增强」走向「长期学习」,为应用开辟更广阔的空间。

4、Agent Tool 爆款频出

Agent Tool 针对大模型的硬伤,补齐短板,让 AI 从「能聊」走向「能做」。因此,这一领域成为当下最炙手可热的创新赛道,爆款频出。

LiteLLM、Supabase、Vercel、ComfyUI、mem0 各自切入关键环节,推理调用、数据存储、记忆管理、外部交互层层推进 AI 的能力边界。

比如 mem0 赋予 Agent 长期记忆与上下文感知;Supabase 快速进化成 GenAI 时代的数据基础设施,解决了实时信息与记忆管理的缺失问题。

而 Browser-use 更是在 9 个月拿下 60K star,让 Agent 真正学会操作网页,成为「落地最后一公里」的标志性项目。

5、Agent Framework下跌明显

2.0 版中,跌幅最大的项目有四个都属于 Agent 编排框架:Eliza、LangChain、LlamaIndex、AutoGen。

一方面这些头部项目在社区投入收缩;另一方面,社区注意力正从通用框架转向应用落地:记忆、工具调用、交互界面等更细颗粒度的创新,正在为未来更强自治的 AI 系统打下基础。

不过,Camel-AI、CrewAI、Agno、ELIZA.OS的冒头,显示「协作智能体」正收获更多关注。

LiveKit Agents 的上榜同样典型,它专注实时交互场景,如语音对话、多人协作,这在过去是图谱里几乎没有覆盖的。

AI Infra:

模型服务狂飙依旧、LLMOps接棒MLOps

虽然远不如 Agent 层的「生命大爆发」,但在 AI Infra 的静水深流中,仍能看到几道涌动的波澜——

云端推理持续内卷、轻量推理的开花、愈发专化的 LLMOps。

2.0版本的AI Infra

1、主力赛道 Model Serving,热力不减

在 2.0 版本里,唯二能与 AI Coding 正面对标的赛道就是 Model Serving。

大模型要落地,推理的效率、成本、安全性是绕不过去的门槛。从 2023 年以来,这条赛道就持续高烧不退,依然是 AI Infra 的主战场。

以 vLLM、SGLang 为代表的高性能云端推理方案仍是主流,生态和社区影响力不断扩张。尤其是 vLLM,稳定性和生态优势使其热度持续坚挺。

大厂也全力加码,NVIDIA TensorRT-LLM 热度居高,新晋的 NVIDIA Dynamo 与之配合,深度绑定 GPU 硬件,正把「推理框架」当作巩固算力垄断的新抓手。

与此同时,本地化也在狂飙。

ollama 让大模型从昂贵的云端「飞入寻常百姓家」,跑在个人电脑甚至移动端。近几个月它的热度虽有小幅下滑,但 GPUStack、ramalama 等新框架迅速补位,说明「轻量 + 云端优化」这条路径依然涌现新玩家。

2、模型运维:LLMOps 接棒 MLOps

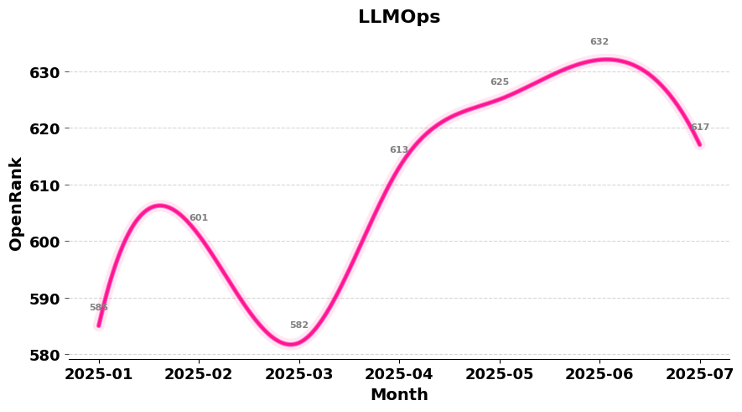

除了 AI Coding、Model Serving,LLMOps 也是 2025 年以来增长最快的主赛道。

Phoenix、Langfuse、Opik、Promptfoo、1Panel、Dagger 等项目,几乎覆盖了从监控、提示词评测到工作流管理的各个环节。

这里的关键转变是,2.0 版本重新定义了「模型运维」:原本分散在模型评测和传统 MLOps 的内容,被整合进大模型的全生命周期管理。关注点也从「小模型时代」的训练精度、数据管道,转向「如何让模型稳定、可控地跑起来」。

换句话说,LLMOps 核心聚焦在监控、提示词效果、可观测性和安全可信上,成为推动大模型真正走向应用的关键支撑。

3、模型训练,跌破年初水平

与前两条赛道的高热不同,模型训练反而一路回调,不仅回吐了涨幅,还跌破了年初水平。

不同行业确实需要不同「口味」的模型。从零开始训练一个 GPT-4 级别模型成本过高,社区更关注如何低成本微调已有模型,比如 Unsloth 集成 QLoRA,在中低端硬件就能跑通。

问题在于应用层成了新的战场:围绕 Chatbot、Agent Tool、Workflow,对开发者更友好,贡献和创新空间更大。

PyTorch 等训练框架早已成熟,增长见顶;Swift、Unsloth、LLaMA-Factory虽短期吸睛,但没能形成持续突破。

4、此外,Ray 在分布式计算上一骑绝尘,TransformerEngine、DeepEP、Triton、Modular等专用内核库的崛起,标志着大模型正在催生属于自己的软件栈,从 Python API 到算子,都需要为 LLM 量身打造。

AI Data,依旧波澜不兴

相较于前两大领域的风云变幻,AI Data 领域显得格外平静。

生态链条已经相当完整,从标注、集成、治理,到向量数据库与搜索,再到上层应用框架,几乎覆盖了数据处理的所有环节。

大多数项目还都是老面孔,诞生于 2014至 2020 年,本质上为 AI 1.0(传统机器学习)时代而生。Chroma 是少数「赶上大模型浪潮」的新秀,2022 年亮相便切中了 RAG 应用的爆发点。

但在热度层面,AI Data 却在持续降温。

我们推测,一部分原因在于这些技术本身已足够成熟,没必要重复造轮子。

像 Iceberg、Delta Lake 这样的数据湖,Milvus、Weaviate、Elasticsearch等向量数据库,早已成为「基础拼图」,经过反复验证后,缺少新的突破口。

另一方面,AI Data 更偏向企业级场景,开发者个人难以直观感受到价值,GitHub 的社区关注度难以持久。

不过,波澜不兴往往孕育着更大的风暴。AI Data 的真正挑战,正在原生大模型时代逐渐显现。例如,向量化一切、RAG、多模态数据处理,数据平台被专家预测将从「仓库」进化为「中枢」——一个智能、动态、实时连接的系统,能持续为模型这个大脑提供真实世界的感知。

因此,旧框架虽依旧稳健,却正被逼近极限。新一代原生于大模型范式的数据基础设施正在酝酿中,AI Data 的下一次波澜壮阔还在蛰伏。

商业博弈,逐渐变味的「开源」

在 2.0 全景图出炉之前,我们就注意到一个微妙趋势:越来越多的大模型项目不再沿用 MIT、Apache 2.0 这类传统开源许可证,而是自拟「开源许可协议」( Open-Source License Agreement ),在开放、控制之间划下灰色地带。

这种新式协议往往保留了许可方更多的干预权。比如,传统协议下,授权一旦给出便不可撤销;但在一些大模型的自拟协议里,这一限制被取消,为后续商业博弈留足了回旋余地。

还有的项目直接按用户规模设限:月活跃用户超过某个数量,就必须另行商议授权。

巧合的是,2.0 全景图的数据也印证了这一观察:新晋项目的 License 多为带有限制性的变体,引发了「算不算开源」的争论。

例如,Dify 采用 BSL(Business Source License)变体,先开放代码,若干年后才切换为宽松协议,以保障商业利益。

n8n 使用 Fair-code,强调「防止大厂白嫖」,Cherry Studio 则在条款中明确了商用需额外授权,体现出对商业模式的防御。

而另一层模糊,来自 GitHub 本身。Cursor、Claude-Code 等项目甚至连代码都闭源,却依旧在 GitHub 上大热,成了厂商收集反馈的窗口。何为「开源社区」在这一波大模型浪潮中,似乎也在被挑战。

番外篇:大模型的战场

作为 Bonus,2.0 版本还特意梳理了 2025 年 1 月至今国内外主流厂商的大模型发布时间线,包含开源、闭源模型,发现了一些有趣的现象。

这张全景图也标注了每个模型的参数、模态等关键信息,帮助理解当下各家厂商的白热化竞争究竟是在哪些方向上展开的。

1. 路线分化:开源 vs 闭源

中国的开源模型依旧百花齐放,而国外顶尖厂商则持续押注闭源。曾凭 Llama 系列对抗闭源阵营的 Meta,如今也逐渐收紧开源节奏。扎克伯格在公开信中直言,「会更谨慎地选择开源什么」。Llama 4 口碑滑铁卢,更让 Meta 的处境尴尬。

这也Callback 了阿里云创始人、之江实验室主任王坚在上海外滩大会开幕式上的判断:开源与闭源的选择,已成为 AI 竞争的关键变量。

2. MoE 架构普及,参数直冲万亿

DeepSeek、Qwen、Kimi 等新旗舰,全面采用专家混合( MoE )架构。凭借「稀疏激活」,模型总参数可以飙升到万亿级别,却只在推理时激活一小部分。K2、Claude Opus、o3 等巨型模型相继登场,性能获得跃升,但也将训练和推理的算力消耗推至新高点。

3. Reasoning:新标配

如果说去年模型发布拼的是「规模」,今年比拼的就是「推理」。DeepSeek R1 借助强化学习大幅增强自动化推理和复杂决策能力,让Reasoning 成为今年模型发布的标配功能。Qwen、Claude、Gemini 甚至引入「快思/慢想」的混合模式,让模型像人一样在任务间切换反应速度。

4. 多模态:全面爆发

过去半年,最强的大脑们不再只盯在语言模型,多模态赛道开始卷了起来。语言、图像、语音交互成为标配,中国厂商在闭源与开源两条线上都取得全球领先。

与此同时,语音模态生态也在兴起:Pipecat、LiveKit Agents、CosyVoice 等工具链正在快速补全版图。

不过,距离视频模态真正成熟,甚至 AGI 的落地,仍有不短的路要走。

5. 模型评价:多元化

多模态的全面爆发,也带动了评价体系的多元化。有人依旧信赖 Design Arena、LMArena 这样的「人投票」平台,用主观偏好来判断模型优劣。也有人更看重客观测试集的分数,用标准答案来衡量模型表现。

与此同时,以 OpenRouter 为代表的 API 网关平台,凭借天然掌握的调用数据,正在形成一种「数据投票」的排行榜。而活跃度持续飙升的 LiteLLM,未来或许也会把调用统计转化为新型评测方式。

文章来自于微信公众号“机器之心”,作者是“关注开源的”。