IT之家 9 月 19 日消息,阿里通义万相全新动作生成模型 Wan2.2-Animate 今日正式开源。该模型支持驱动人物、动漫形象和动物照片,可应用于短视频创作、舞蹈模板生成、动漫制作等领域。

Wan2.2-Animate 模型基于此前通义万相开源的 Animate Anyone 模型全面升级,不仅在人物一致性、生成质量等指标上大幅提升,还同时支持动作模仿和角色扮演两种模式:

角色模仿:输入一张角色图片和一段参考视频,可将视频角色的动作、表情迁移到图片角色中,赋予图片角色动态表现力;

角色扮演:同时还可在保留原始视频的动作、表情及环境的基础上,将视频中的角色替换为图片中的角色。

此次,通义万相团队构建了一个涵盖说话、面部表情和身体动作的大规模人物视频数据集,并基于通义万相图生视频模型进行后训练。

Wan2.2-Animate 将角色信息、环境信息和动作等,规范到一种统一的表示格式,实现了单一模型同时兼容两种推理模式;针对身体运动和脸部表情,分别使用骨骼信号和隐式特征,配合动作重定向模块,实现动作和表情的精准复刻。在替换模式中,团队还设计了一个独立的光照融合 LoRA,用于保证完美的光照融合效果。

实测结果显示,Wan2.2-Animate 在视频生成质量、主体一致性和感知损失等关键指标上,超越了 StableAnimator、LivePortrait 等开源模型,是目前性能最强的动作生成模型,在人类主观评测中,Wan2.2-Animate 甚至超越了以 Runway Act-two 代表的闭源模型。

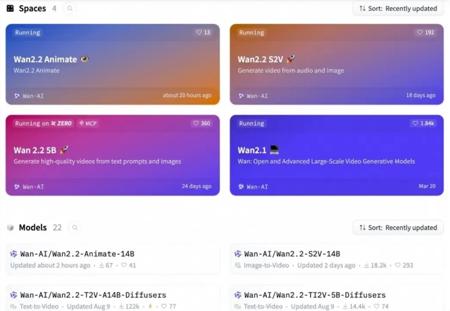

即日起,用户可在 Github、HuggingFace 和魔搭社区下载模型和代码,也可以在阿里云百炼平台调用 API,或通义万相官网直接体验。IT之家附开源地址如下:

https://github.com/Wan-Video/Wan2.2

https://modelscope.cn/models/Wan-AI/Wan2.2-Animate-14B

https://huggingface.co/Wan-AI/Wan2.2-Animate-14B

广告声明:文内含有的对外跳转链接(包括不限于超链接、二维码、口令等形式),用于传递更多信息,节省甄选时间,结果仅供参考,IT之家所有文章均包含本声明。